Das Aufkommen von generativer KI und den dazugehörigen Large Language Models (LLMs) eröffnet völlig neue Möglichkeiten für Bots, um Interaktionen natürlicher, vielseitiger und effizienter zu gestalten. Verschiedene Anbieter bieten Modelle an, die flexibel in unterschiedliche Anwendungen integriert werden können.

Die meisten dieser Modelle sind ausschließlich in der Cloud verfügbar, während einige auch als On-Premises-Lösungen installiert werden können. Unabhängig davon, ob sie in der Cloud oder lokal eingesetzt werden, sollte die Nutzung stets DSGVO-konform erfolgen und den Anforderungen des EU AI Acts entsprechen, um rechtliche und ethische Standards einzuhalten.

Generative KI kann auf mehreren Ebenen eingesetzt werden, um Bots zu unterstützen und ihre Leistungsfähigkeit zu erweitern:

1. Unterstützung bei der Erstellung von Bots

2. KI-Assistenten zur Interaktion

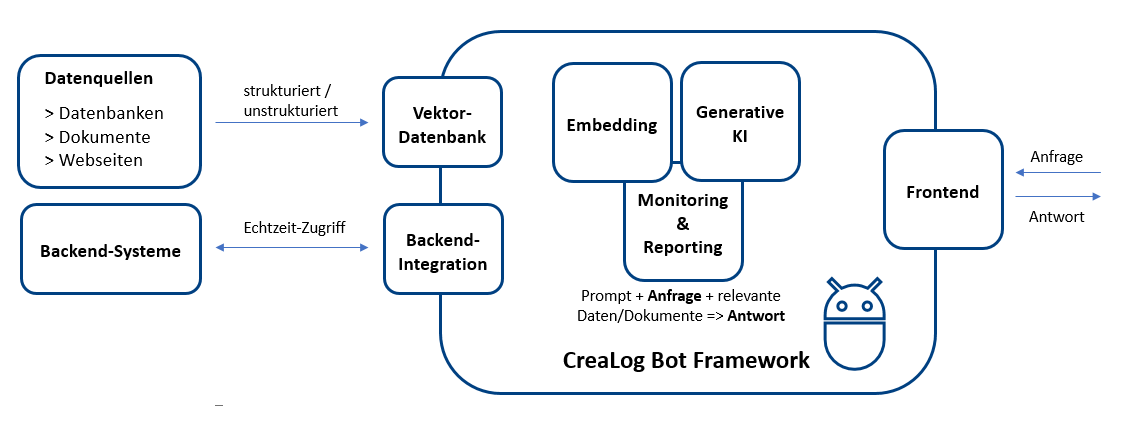

3. Retrieval-Augmented Generation (RAG)

Ein RAG-System besteht aus zwei zentralen Komponenten:

1. Embedding

2. Generierung der Antwort

Beim Einsatz von generativer KI müssen ethische und rechtliche Vorgaben, wie die DSGVO oder der EU AI Act, berücksichtigt werden. Insbesondere beim Umgang mit sensiblen Daten oder der Beantwortung kritischer Anfragen ist Transparenz entscheidend.

Das CreaLog Bot Framework bietet umfangreiche Monitoring- und Analyse-Möglichkeiten, die:

Generative KI, unterstützt durch leistungsstarke Modelle und Architekturen wie RAG, revolutioniert die Art und Weise, wie Bots Inhalte verarbeiten, Wissen abrufen und mit Nutzern interagieren. Durch die Kombination von Echtzeitdaten, intelligenter Analyse und benutzerzentrierten Antworten schaffen Bots nicht nur eine effizientere Interaktion, sondern setzen auch neue Standards in der digitalen Kommunikation.